Combien de mauvaises décisions prenons-nous sur la base d’informations erronées ou manquantes ? Combien de factures impayées pour cause d’envoi à la mauvaise adresse ? Combien encore de mauvaises décisions de crédit en raison de bilans erronés qui entraînent de mauvaises analyses ?

Ce sont autant de dépenses supplémentaires et de trésorerie perdue dans les entreprises.

Comment éviter les pièges liés à une mauvaise donnée ?

Les résultats faussés sont inévitables avec de mauvaises données dont on n’a évidemment pas conscience, et les données évoluent beaucoup et rapidement. A savoir, en 1 heure, ce sont 127 sociétés qui ferment, 77 qui défaillent, 700 qui sont créées ou changent d’adresse, et plus de 1000 qui changent de dirigeants ou d’enseignes. Une mise en place de contrôle est alors indispensable pour s’assurer de la fiabilité des données, et les corriger le cas échéant.

Il faut également se montrer vigilant quant aux biais de collecte, qui influent sur la qualité de l’information recueillie :

- la saisie manuelle qui peut entraîner des erreurs et un manque de complétude,

- la négligence des sources de données qui ne sont pas à jour,

- la non-exhaustivité de la population sous suivi,

- l’asymétrie de traitement imputable au format de la donnée,

- l’absence de normalisation de la source de données,

- la censure de l’information.

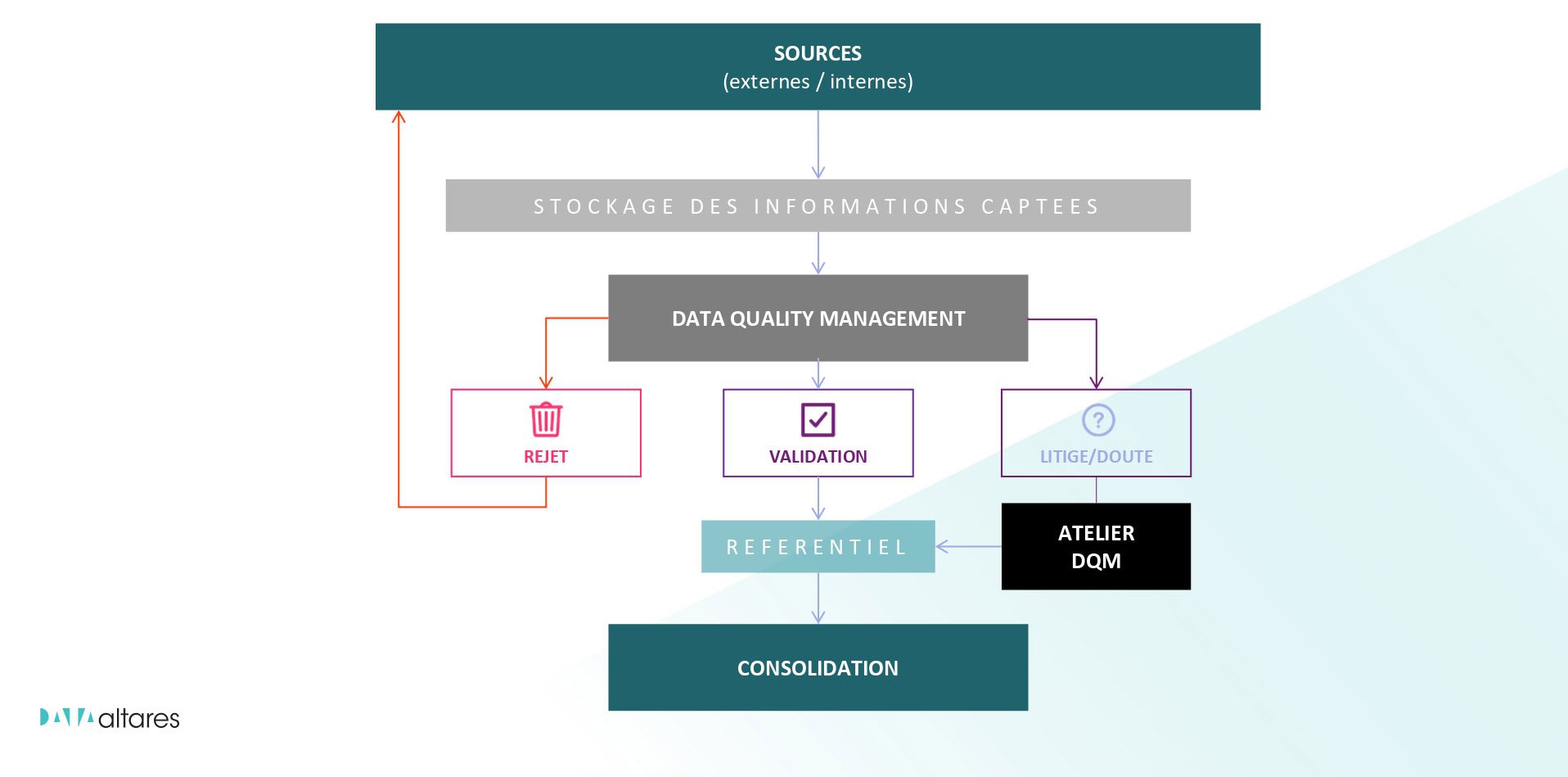

Comment corriger les erreurs sur les données ?

Les trois éléments clés pour une donnée fiable sont :

- bien identifier,

- distinguer caractéristiques (informations légales & administratives) et contexte (données commerciales),

- et s’assurer de la mise à jour des informations.

Pour se faire, la gouvernance data est un indispensable pour prendre de bonnes décisions.

Quelles évolutions sur la collecte d’information ?

Ces 10 dernières années ont vu bon nombre de bouleversements concernant la gestion de la donnée. La mise en place de la République numérique en 2012 a concrétisé la mise en place de l’open data (la donnée en accès libre et gratuite). Par ailleurs, le RGPD a instauré une norme sur la confidentialité des informations personnelles. Au-delà des informations sur les individus, un certain nombre d’entreprises peuvent opter pour la non-diffusibilité de leurs bilans. En outre, le RNE (Registre National des Entreprises) va garantir l’uniformité des données.

Pour assurer la qualité de la donnée, Altares en garantit l’exhaustivité, la maintenabilité (à jour), l’homogénéité (sources contradictoires ?), la lisibilité et la réactivité.

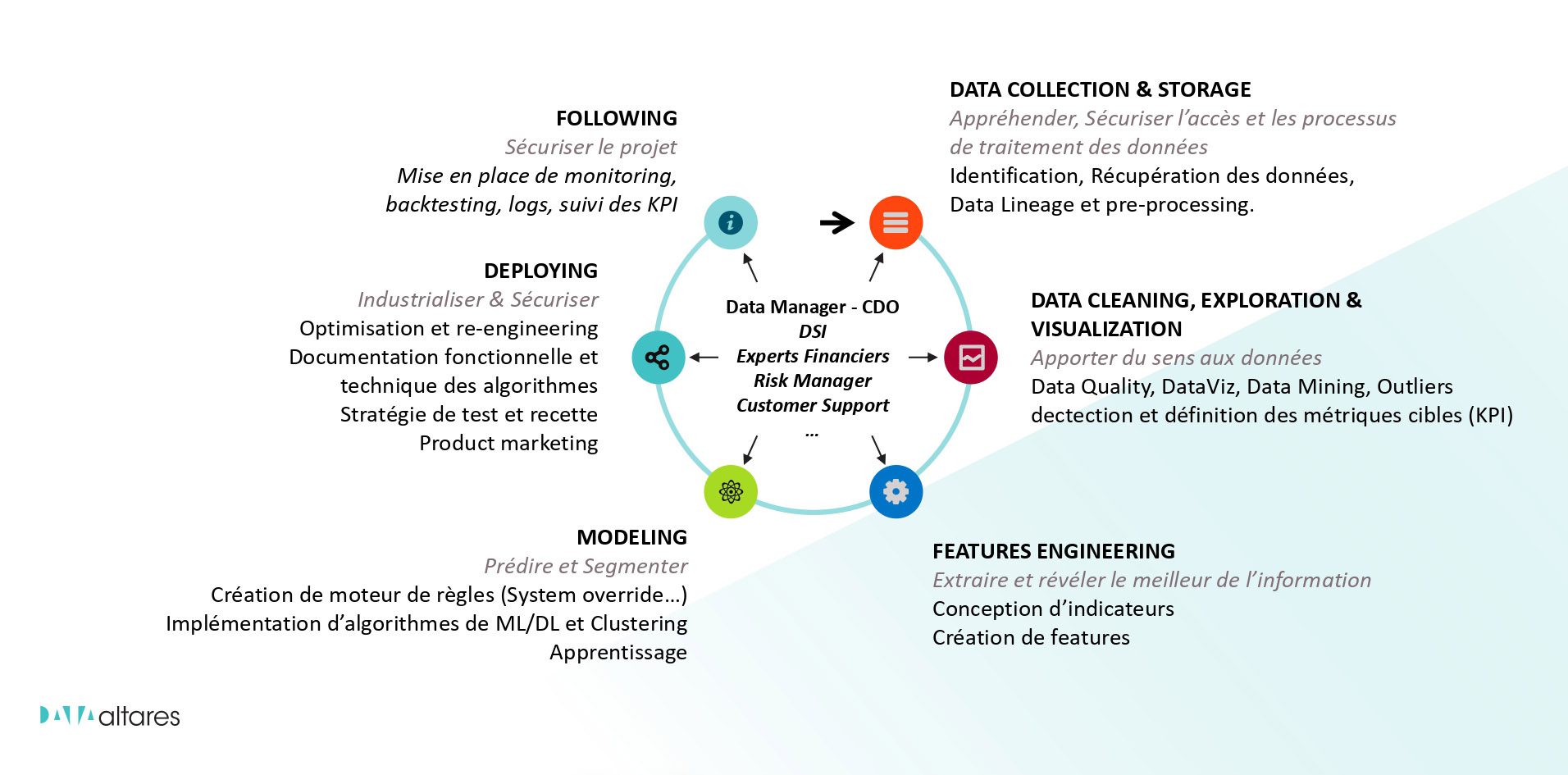

Bien mener un projet de Data Science

Au-delà de la véracité de la donnée, il est nécessaire de se pencher sur la question de l’exploitation de cette donnée. La donnée brute ne suffit pas, elle doit être analysée pour en tirer des résultats permettant d’aboutir à une prise de décision.

La Data Science est un carrefour de compétences qui engagent des nombreuses expertises autour de 6 étapes clés :

- collecte et sécurisation de la data,

- nettoyage et qualification de la donnée,

- conception d’indicateurs,

- modélisation pour prédire et segmenter,

- déploiement,

- suivi par la mise en place d’un monitoring du produit.

Quels prérequis pour permettre l’automatisation de la prise de décision ?

Tout ces processus inhérents à la collecte, la qualification et l’analyse de la donnée ne visent qu’un seul but : automatiser la prise de décision. Pour cela, la donnée doit respecter 3 critères principaux, en plus de sa véracité constante :

- utilité,

- lisibilité, pour une donnée compréhensible,

- interconnectivité, pour donner toute sa valeur à la donnée.

Mais cela ne suffit pas, pour prédire l’avenir, il faut disposer d’un historique. L’historisation nécessite un traçage des informations dans le temps, depuis leur collecte jusqu’à leur livraison.

L’automatisation décisionnelle entraîne de profonds bouleversements, mais heureusement, la décision finale demeure le privilège de l’humain, qui voit l’automatisation comme une aide et non un remplacement.

N’hésitez pas à visionner le replay du webinar qui s’est tenu le 11 mai, animé par plusieurs experts d’Altares : Frédéric Paresy – Data Product Manager, Alexandre Zavagno – Data Scientist, Philippe Lièvre – Expert Etudes Financières, et Gilles Lambert – Product Marketing Manager Risk.