Camille RENAUD

Content marketing manager

L’intelligence artificielle transforme les métiers et tout particulièrement le secteur bancaire, pionnier dans son usage. S’agissant d’un des secteurs les plus régulés, cela soulève d’importants défis de conformité et d’éthique.

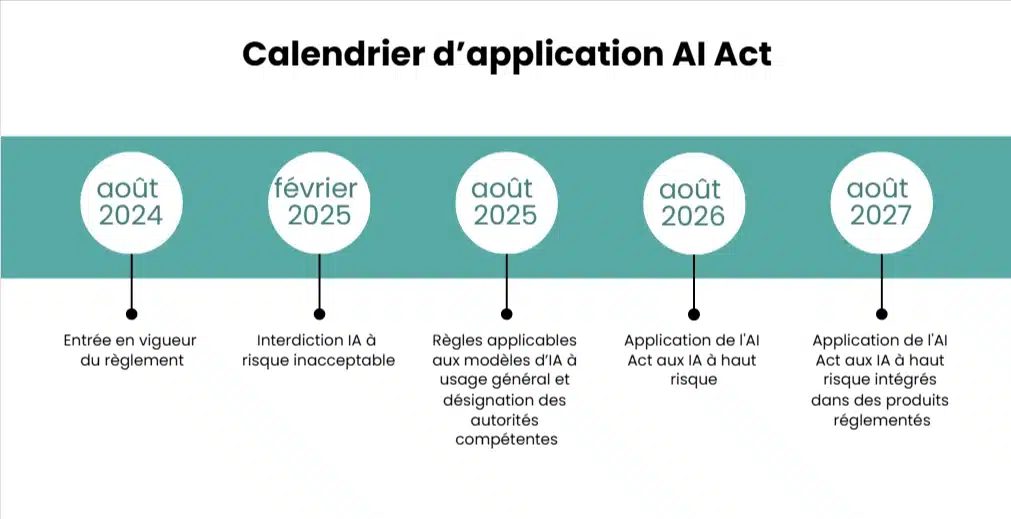

Les institutions financières voient aujourd’hui se combiner deux cadres réglementaires européens majeurs : le RGPD, pilier de la protection des données personnelles depuis 2018, et l’AI Act, premier règlement mondial dédié aux systèmes d’IA, entré en vigueur en août 2024 et qui se déploiera progressivement jusqu’en 2027.

Le secteur bancaire : un environnement ultra-réglementé

Les banques sont historiquement fortement dépendantes de la donnée (données clients, données transactionnelles, etc.) et utilisent déjà des modèles d’intelligence artificielle pour le scoring de crédit, la gestion du risque, la détection de la fraude, la conformité, la lutte anti-blanchiment, la personnalisation des offres, et la relation client (chatbots, recommandations, etc.).

Ces usages s’appuient sur des données hautement sensibles, protégées par le RGPD, et désormais soumises aux exigences de l’AI Act.

Le RGPD responsabilise les banques dans la gestion des données personnelles. L’IA Act ajoute une couche réglementaire dédiée aux systèmes d’IA, classés selon leur niveau de risque. Pour les banques, cela concerne particulièrement les solutions de scoring de crédit, de lutte contre la fraude, et de gestion automatisée des clients.

Deux réglementations complémentaires, un socle commun

Le RGPD : pilier de la conformité des données personnelles

Le RGPD encadre l’ensemble des traitements de données personnelles. Il impose :

- une base légale et une finalité déterminée ;

- la transparence vis-à-vis des personnes concernées ;

- la minimisation des données et leur sécurité ;

- des droits individuels (accès, rectification, opposition, portabilité, effacement) ;

- une vigilance accrue sur les décisions entièrement automatisées (article 22) ;

- la réalisation d’analyses d’impact (AIPD) pour les traitements à risque élevé.

Dans un contexte bancaire, cela signifie notamment que les modèles d’IA utilisés pour accorder un crédit ou détecter une anomalie doivent être documentés, explicables, et fondés sur des données pertinentes.

Mais le RGPD n’a pas été spécifiquement conçu pour l’IA, et son champ d’application devient insuffisant au regard de l’essor de l’IA et de la façon dont elle utilise les données. C’est là qu’entre en jeu l’AI Act.

L’AI Act : pilier de la conformité des systèmes d’IA

L’AI Act est la première réglementation européenne adoptée par l’UE pour encadrer l’utilisation de l’intelligence artificielle.

Il introduit un cadre juridique pour les systèmes d’IA selon leur niveau de risque :

- risque inacceptable(qui porte atteinte aux valeurs fondamentales telles que la dignité) : interdit ;

- risque élevé(notamment secteur de la santé, de l’éducation, du recrutement…) : autorisé sous conditions strictes ;

- risque limité(génération d’images, de sons et de vidéos) : obligations de transparence ;

- risque minimal( IA de jeux vidéo ou filtres anti-spam) : libre usage.

Dans le secteur bancaire, certains cas d’usage sont explicitement qualifiés de « haut risque », notamment :

- l’évaluation du crédit des personnes physiques ;

- l’analyse de solvabilité pour l’accès à des services financiers essentiels ;

- les systèmes utilisés dans le recrutement ou l’évaluation du personnel.

En conséquence, ils devront être documentés, audités et leurs modèles explicités.

D’autres usages fréquents (détection de fraude, AML, service client) ne sont pas automatiquement classés en “haut risque” et doivent être qualifiés au cas par cas selon les annexes du règlement.

Les deux règlements – RGPD et AI Act – se complètent. Une IA bancaire traitant des données personnelles devra donc être doublement conforme : au RGPD pour la gestion des données personnelles et à l’AI Act pour la conception, l’usage et la supervision du modèle.

Les enjeux pour le secteur bancaire

Gouvernance et responsabilité : Les banques devront instaurer une gouvernance IA alignée sur le RGPD et l’AI Act, en cartographiant les cas d’usage IA, en instaurant un comité éthique et conformité, en nommant un responsable de la conformité IA, en formant les équipes et en alimentant une documentation technique et juridique des modèles.

Transparence et explicabilité : L’AI Act et le RGPD imposent que les décisions automatisées puissent être expliquées et justifiées.

Lutte contre les biais et discriminations algorithmiques : Les modèles de scoring ou de détection de fraude doivent démontrer leur équité et absence de biais. Cela implique un contrôle des jeux de données et des audits périodiques.

Sécurité et souveraineté : L’AI Act renvoie aussi à la sécurité des systèmes, à leur robustesse et leur protection contre les attaques. En parallèle, les banques doivent préserver la souveraineté des données (hébergement, Cloud européen conforme RGPD et la protection des flux de données).

Opportunités et bénéfices

Loin d’être uniquement une contrainte, ce nouveau cadre peut devenir un levier de confiance et de compétitivité. Il permettra de positionner la banque comme acteur de confiance dans l’économie de la donnée. Il a vocation à améliorer la qualité des modèles d’IA par ses exigences de transparence et de gouvernance. Il offrira aussi un accès facilité aux marchés publics ou partenariats européens, où la conformité à l’AI Act sera un prérequis.

Le croisement du RGPD et de l’IA Act marque un tournant : il ne s’agit plus seulement de protéger la donnée, mais de protéger aussi la décision.

Pour le secteur bancaire, c’est l’opportunité d’aligner innovation, conformité et confiance, et de devenir un modèle européen d’IA responsable, à la fois performante, explicable et souveraine.

Pour en savoir + sur la façon dont Altares accompagne le secteur bancaire, rendez-vous sur notre page dédiée :